DeepSeek本地部署以及使用体验

最近,国内一家名为DeepSeek的初创公司通过技术迭代与升级,推出了全新一代大模型“DeepSeek-V3”。这款大模型因其卓越的性能和易用性,迅速在AI爱好者中引起了广泛关注。更令人瞩目的是,DeepSeek R1版本直接免费开源,这一举动迅速在AI发烧友圈中传播开来,并迅速扩散到海外社交平台和技术论坛。海外网友对此纷纷表示赞叹,称其为AI领域的一大突破。

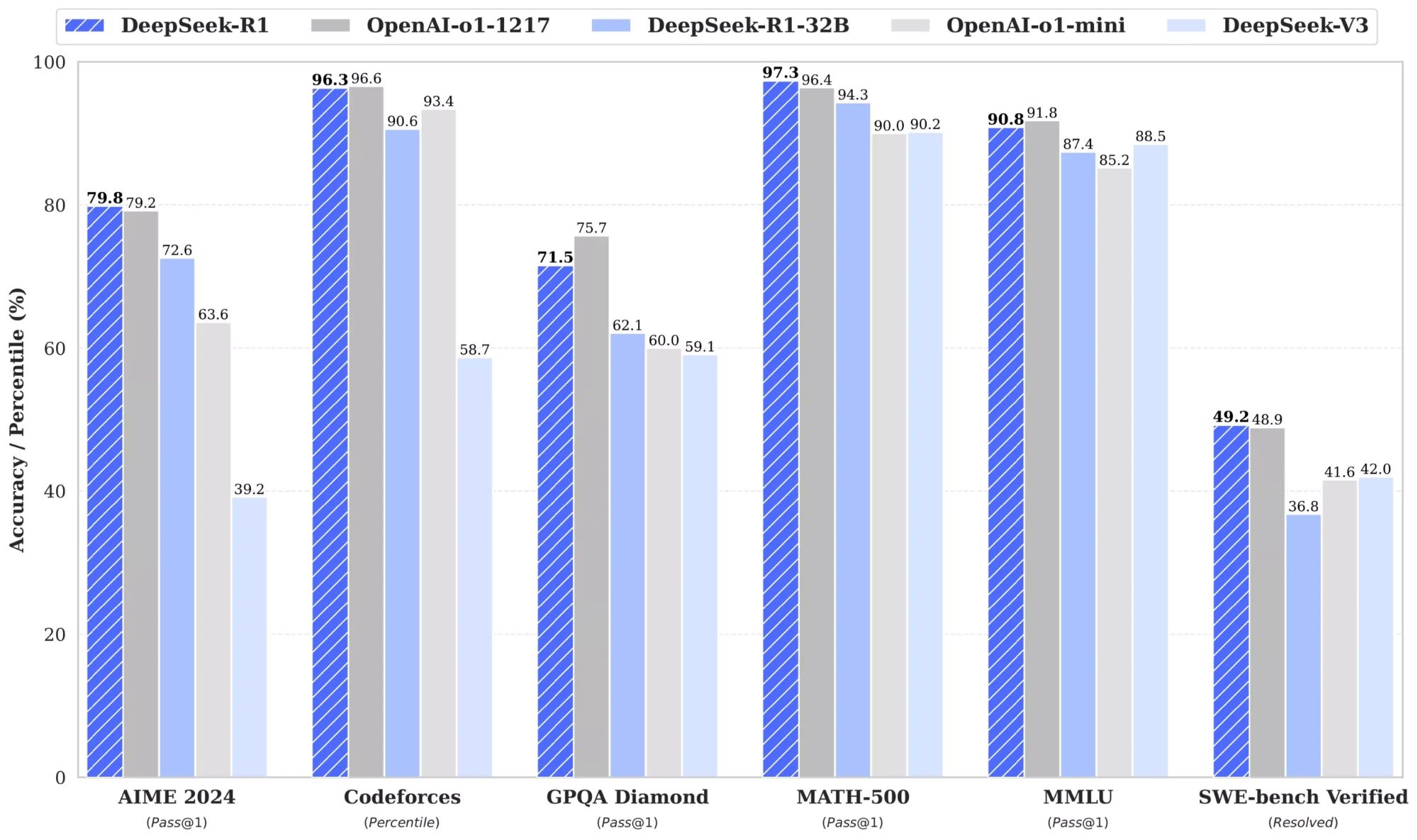

它的研发成本大概600万美金,不到openai的1%,各项性能指标更是和OpenAI-o1 模型不相上下,甚至做到了小部分的超越,关键是开源的,我们可以本地部署使用。

本地部署,我们可以通过Ollama来进行安装

Ollama 官方版:【点击前往】

Web UI 控制端【点击安装】

安装命令

1.5B Qwen DeepSeek R1

7B Qwen DeepSeek R1

8B Llama DeepSeek R1

14B Qwen DeepSeek R1

32B Qwen DeepSeek R1

70B Llama DeepSeek R1

DeepSeek和chatgpt比较,我就本地部署deepseek的时候想了一个问题,比较一下确实能分出高低,deepseek马上猜出我的电脑配置,而chatgpt没有,虽然我的电脑售卖的时候是有好几种内存和显卡配置的,当然,我的问题最好写得更具体,当我就应该是不懂的那种:

问题:

我的电脑是Lenovo Legion R7000 2020,帮我推荐安装哪个deepaeek模型:

DeepSeek回答:

根据 Lenovo Legion R7000 2020 的硬件配置(通常是 16GB 内存 + GTX 1650/1660 Ti 显卡),建议选择较小的模型,因为较大的模型需要更多的显存和计算资源。以下是适合你电脑配置的推荐:

推荐选择:

- 1.5B Qwen DeepSeek R1

- 模型较小,适合 16GB 内存和 GTX 1650/1660 Ti 级别的显卡。

- 运行速度快,对硬件要求较低。

- 命令:

ollama run deepseek-r1:1.5b

- 7B Qwen DeepSeek R1

- 如果你的显卡显存较大(如 6GB 以上),可以尝试 7B 模型。

- 可能需要降低批处理大小(batch size)以避免显存不足。

- 命令:

ollama run deepseek-r1:7b

- 8B Llama DeepSeek R1

- 类似于 7B 模型,适合显存较大的配置。

- 命令:

ollama run deepseek-r1:8b

不推荐选择:

- 14B、32B、70B 模型

这些模型对显存和计算资源要求非常高,通常需要 24GB 以上显存的高端显卡(如 RTX 3090、A100 等),不适合你的电脑配置。

总结:

如果你的显卡显存较小(如 4GB),建议选择 1.5B 模型;如果显存较大(6GB 以上),可以尝试 7B 或 8B 模型。运行前请确保安装了最新的显卡驱动,并关闭不必要的后台程序以释放资源。

chatgpt回答:

要选择适合你 Lenovo Legion R7000 2020 配置的本地 AI 模型,主要需要考虑你的计算机硬件配置,尤其是显卡(GPU)和内存(RAM)的性能。你提供的机器大致配置应该包括较强的处理能力,但具体能跑哪些模型,取决于内存和显卡性能。

通常来说,模型越大,占用的显存和内存就越多。如果你的电脑配备了高性能的显卡(例如 NVIDIA RTX 3060 或更高),并且有足够的内存(16GB 或更高),可以考虑使用较大的模型。以下是对比这些模型的建议:

1. 1.5B Qwen DeepSeek R1

- 适用条件:这是一个相对较小的模型,对显卡和内存要求较低。基本上,几乎所有配置的电脑都可以运行它,特别适合资源有限的机器。

2. 7B Qwen DeepSeek R1

- 适用条件:虽然较大一些,但如果你的电脑有较强的 GPU(比如 RTX 3060 及以上)和至少 16GB 内存,它是一个可以运行的模型。

3. 8B Llama DeepSeek R1

- 适用条件:这个模型对显卡要求更高,可能需要更多的显存和更快的 GPU。如果你的电脑配备了强大的显卡和 16GB 以上的内存,可以考虑。

4. 14B Qwen DeepSeek R1

- 适用条件:这个模型较大,通常需要更强的 GPU 和较大的内存(可能需要 24GB 或更高的显存)。适合高端配置的机器。

5. 32B Qwen DeepSeek R1

- 适用条件:32B 的模型非常庞大,可能需要顶级显卡和至少 32GB 内存。一般来说,普通玩家的机器可能难以运行此类模型。

6. 70B Llama DeepSeek R1

- 适用条件:这是一个极为庞大的模型,只有配备顶级硬件的机器(例如 A100 GPU 或等效硬件)才能够高效运行此类模型。普通游戏笔记本不适合运行如此大的模型。

综合建议:

- 如果你有较好的 GPU(例如 RTX 3060 或更高)和 16GB 或更多内存,7B Qwen DeepSeek R1 或 8B Llama DeepSeek R1 会是比较合适的选择。

- 如果你是低端显卡或内存较少的配置,选择 1.5B Qwen DeepSeek R1 会更为合适。

最终选择哪个模型,还是要依据你电脑的具体硬件配置来决定。如果你不确定具体的硬件要求,可以先尝试运行小模型,看是否能够稳定运行,再逐步增加模型的规模。

代码测试:

对我来说,更多的是在编程方面的应用,这也是为什么,本来ai可以帮助写作的这段期间,写作应该更简单更快,但我的博客更新率反而降低,因为我最近几乎都在用ai编程,忙得停不下来,最近又做了一套预约系统(客户需求),一个不精通编程的人,因为有了ai便有了希望。

目前利用ai编程,尤其是我这样的水平,很多时候需要丢一大堆代码来进行功能的添加,为的也是不想拆分一段段的代码去解释和修改,虽然ai也能给你答案,但是折腾起来挺费时费力,所以一开始就要想好全部需要的功能,一次性让ai都考虑在内,当然,如果你的系统太复杂,目前有些ai免费版输出的代码有字数限制。

根据我目前的使用心得,在deepaeek还没出来的时候,claude.ai的编程能力最强,但由于字数限制,有经常还得把代码搬到kimi.ai那边去继续修复,kimi.ai主要特点是输出内容比较长,但是编程能力相对会低一些,现在由于deepseek的出现,经过测试,输出内容好像比kimi.ai更长,编程能力和claude不相上下,我测试过一段mercadopago的支付,写出来的代码可用,说明编程能力还是可以的,虽然感觉过去和claude还是有一丁点差距,不过已经非常好了,至少是免费而且没有限制,真的狂喜。

我也看到过做中文文案的人的评测,说DeepSeek的中文能力比chatgpt强,语言组织上更适合中国人的思维,这点也是做自媒体文案的人的总结。

这几天因为deepseek太火,以至于受到海外的网络攻击,也因为访问量太大,各种卡顿,所以本地部署也是一个选择,经过测试,配置选择越大效果会越好。

下一篇:用trae编程

想请教下博主,本地部署DeepSeek有什么特别的用途,训练自己的数据不是要大量的数据素材么

@小彦 deepseek应该是训练好的吧,部署完应该不需要训练直接离线可用吧,同问。

@小彦 就是凑个热闹,体验一把,1.5B真的没有必要,太弱,那个模型已经训练好了,只是能力没有满血版强,基础的语言问答没什么问题。

我觉得主要是免费、便宜,但稳定性一般,有时感觉很强有时又会犯傻。当然不能持续性也是所有ai的弊端,协助编程有时反被折腾。项目模块化让它帮忙可能比较好点。

本地部署你测试感觉如何?怕电脑算力不够,文字类本地部署没搞过,图片类测试过——慢的一批(我的显卡是4070s)

@zwwooooo 我一直用cursor免费期的,很方便,小问题的就chatgpt,我的是笔记本,性能跟不上,部署1.5B的没啥意义,我看到网上有人部署671B那个官方的满血版的,用C盘的内存当虚拟内存来带动,不过回答的速度还是感人,很慢,但确实被部署进去了。也有人租网络的来测试,这样的机型贵但库存也很少,编程的话推荐cursor,真的太方便了,使用claude 3.5的,我个人测试这么多ai,就claude 3.5 最强,这是deepseek出来之前的结论,现在各大ai又一次大升级,像刚开始感觉很弱的gemini现在也退出2.0的,感觉也还行,因为有了cursor,就基本很少再去问其他ai了。

@郑永 不会是零度解说吧![[坏笑]](https://xptt.com/wp-content/themes/xptt-feng-2019/images/smilies/icon_mrgreen.gif)

@zwwooooo 就是哈

@zwwooooo 现在有专研ai去做项目的话,还是可以赚钱的,比如搞插件,短剧剧本,或则是其他能利用上ai生成的东西都可以搞等等,确实提升很多,应用很广,不像之前那个只能是玩玩。

DeepSeek确实很好用,我现在写脚本都会让DeepSeek给参谋一下1

@明月登楼 ai对写代码这一块确实节省不少时间,而且以前几乎折腾不来的难度现在也能折腾,对新手来说提升相当大,不可能变成可能。

最近也在准备试试小模型,倒不是要求有多强大,毕竟体积在那里,主要是看一些能力,比如文本归类、判断什么的,作为智能化的一个服务放到业务流程里面去

电脑配置不行,想本地部署一个小点的,做资料分类打标签不知道好不好用

32G内存本地部署了7B,还是感觉傻傻的。现在买了DS的API,用起来不要太好

deepseek老是掉线是真的烦人,会员是不是还是不能开通

怎么感觉在那里见过这篇文章呢?

现在都是使用在线的

本地担心显卡扛不住